Azure Data Factory: entendendo seu funcionamento

As empresas enfrentam um crescimento contínuo no volume de dados que precisam gerenciar. Desde os aplicativos que utilizamos diariamente, passando pelos sistemas operacionais internos, até os inúmeros dispositivos conectados que fazem parte da nossa rotina, a produção e coleta de informações estão sempre em ascensão.

Com tanta informação vindo de todos os cantos, o desafio não é apenas coletar, mas organizar, atualizar e tornar esses dados úteis. Imagine tentar tomar uma decisão crítica sem ter certeza de que você está usando os dados mais recentes e relevantes. É aí que entra a necessidade de uma ferramenta eficaz, que não apenas gerencie, mas também processe e integre esses dados de forma confiável. E uma solução que vem ganhando destaque para atender a essa demanda é o Azure Data Factory.

O que é o Azure Data Factory?

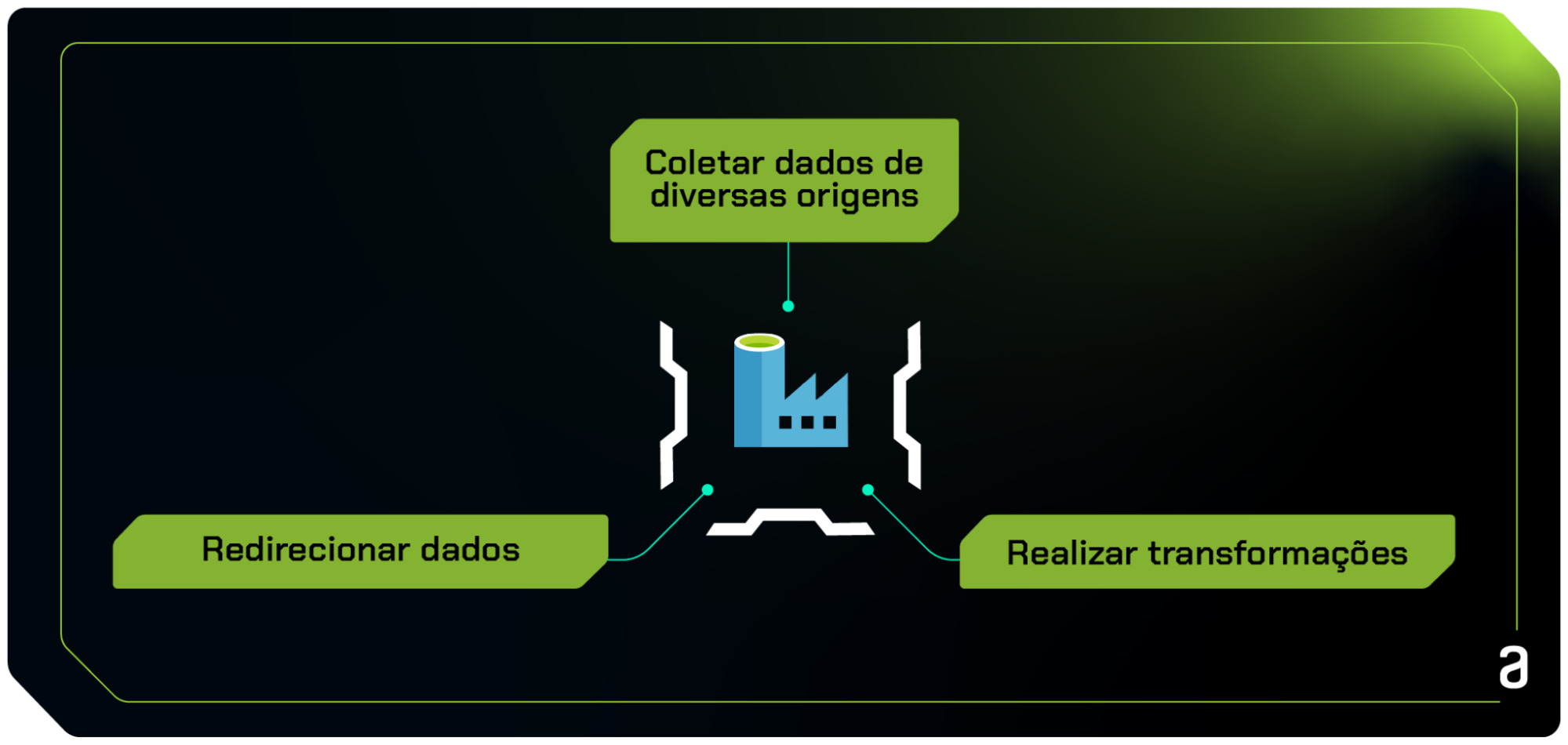

Azure Data Factory é uma solução em nuvem oferecida pela Microsoft, construída para resolver desafios comuns na gestão de dados. Ele atua principalmente como um serviço de integração, permitindo que as empresas organizem, agendem e automatizem o fluxo de informações. Com o Data Factory, é possível coletar dados de diversas origens, realizar transformações necessárias e depois direcionar esses dados para um destino específico.

Um dos pontos fortes deste serviço é a "orquestração". Em termos simples, orquestração é a coordenação de várias tarefas, garantindo que elas aconteçam na sequência correta e no momento certo. Por exemplo, antes de analisar um dado, você precisa ter certeza de que ele foi coletado e transformado corretamente. O Azure Data Factory gerencia essa coordenação, garantindo que cada passo no fluxo de dados seja executado de forma eficiente e ordenada.

Como funciona o Azure Data Factory?

O Azure Data Factory opera através de um modelo de fluxo de trabalho definido por pipelines. Imagine um pipeline como uma linha de montagem de fábrica: cada estágio do processo é cuidadosamente orquestrado para garantir que os dados se movam e se transformem da maneira correta. O processo geralmente começa identificando e conectando-se a uma ou mais fontes de dados. Uma vez conectado, os dados são extraídos, podem ser transformados ou enriquecidos conforme as necessidades específicas e, por fim, carregados em um destino final.

Dentro do pipeline, o Data Factory permite que os engenheiros definam atividades de "movimento de dados" e "transformação de dados". O "movimento de dados" refere-se à extração e carregamento de dados de uma fonte para um destino, enquanto a "transformação de dados" permite que os dados sejam processados ou modificados - por exemplo, limpeza de dados, agregação, enriquecimento, entre outros.

A orquestração eficaz destas atividades é essencial. Com o Azure Data Factory, é possível definir dependências entre atividades, garantindo que cada passo só ocorra após a conclusão bem-sucedida do passo anterior. Isso é fundamental para manter a integridade e a confiabilidade dos dados processados.

Principais Componentes

Dentro da estrutura do Azure Data Factory, existem vários componentes chave que trabalham juntos para assegurar sua eficácia e funcionalidade:

- Linked Services: podemos pensar neles como os "conectores" do Data Factory. Eles fornecem informações sobre como o Data Factory pode se conectar a fontes de dados externas ou serviços de computação. Estes podem variar desde bancos de dados locais, sistemas de armazenamento em nuvem até APIs web.

- Datasets: são estruturas de dados, semelhantes a tabelas, arquivos ou objetos, que definem os dados que você deseja mover e transformar. Eles representam a estrutura dos dados, o esquema e outros detalhes técnicos.

- Pipelines: um pipeline é uma série de atividades. Cada atividade dentro de um pipeline realiza uma operação específica, como copiar dados de uma fonte ou aplicar uma transformação.

- Activities: são as ações ou tarefas dentro de um pipeline. Elas podem ser tão simples quanto copiar dados de um local para outro, ou tão complexas quanto aplicar algoritmos de análise avançada aos dados.

- Triggers: como o próprio nome sugere, são os "disparadores" para iniciar um pipeline. Eles podem ser configurados para iniciar um pipeline em um horário específico, em intervalos regulares ou em resposta a um evento, como a chegada de novos dados.

- Debugging & Monitoring Tools: o Azure Data Factory oferece ferramentas integradas para depurar e monitorar pipelines. Estas ferramentas são essenciais para garantir que os pipelines operem corretamente e para identificar rapidamente qualquer problema ou ineficiência que possa surgir.

Integração com Azure Data Lake

A combinação do Azure Data Factory com o Azure Data Lake representa um salto significativo em eficiência na gestão de dados. Juntos, esses serviços proporcionam uma solução abrangente que aborda tanto a coleta e transformação de dados quanto seu armazenamento seguro e escalável.

O Azure Data Lake é projetado para armazenar vastos volumes de dados, abrangendo desde informações estruturadas até dados não estruturados. Seja um conjunto de tabelas de banco de dados, registros de logs ou documentos, o Data Lake os mantém seguros e acessíveis.

Por sua vez, o Azure Data Factory destaca-se na movimentação e transformação desses dados. Com sua capacidade de integração ao Azure Data Lake, as empresas têm a vantagem de coletar dados de diversas fontes, processá-los conforme necessário e armazená-los diretamente no Data Lake. Isso não só otimiza a preparação dos dados para análises futuras, mas também garante que eles estejam sempre no local certo, no formato certo e prontos para uso.

Conclusão

À medida que as empresas lidam com volumes crescentes de dados, a necessidade de ferramentas eficientes de gerenciamento de dados torna-se cada vez mais crucial. O Azure Data Factory, em integração com o Azure Data Lake, oferece uma solução robusta que atende a essa demanda. Ele simplifica tarefas complexas, garantindo a coleta, transformação e armazenamento adequados dos dados. Com as ferramentas certas à disposição, as empresas podem assegurar a qualidade e relevância das informações, fortalecendo suas decisões e estratégias.

Caso queira se aprofundar e aprender mais sobre o Azure Data Factory e o Azure Data Lake, não deixe de conferir o curso Databricks e Data Factory: criando e orquestrando pipelines na nuvem.

Créditos

- Conteúdo: Millena Gená

- Produção técnica: Rodrigo Dias

- Produção didática: Morgana Gomes

- Designer gráfico: Alysson Manso