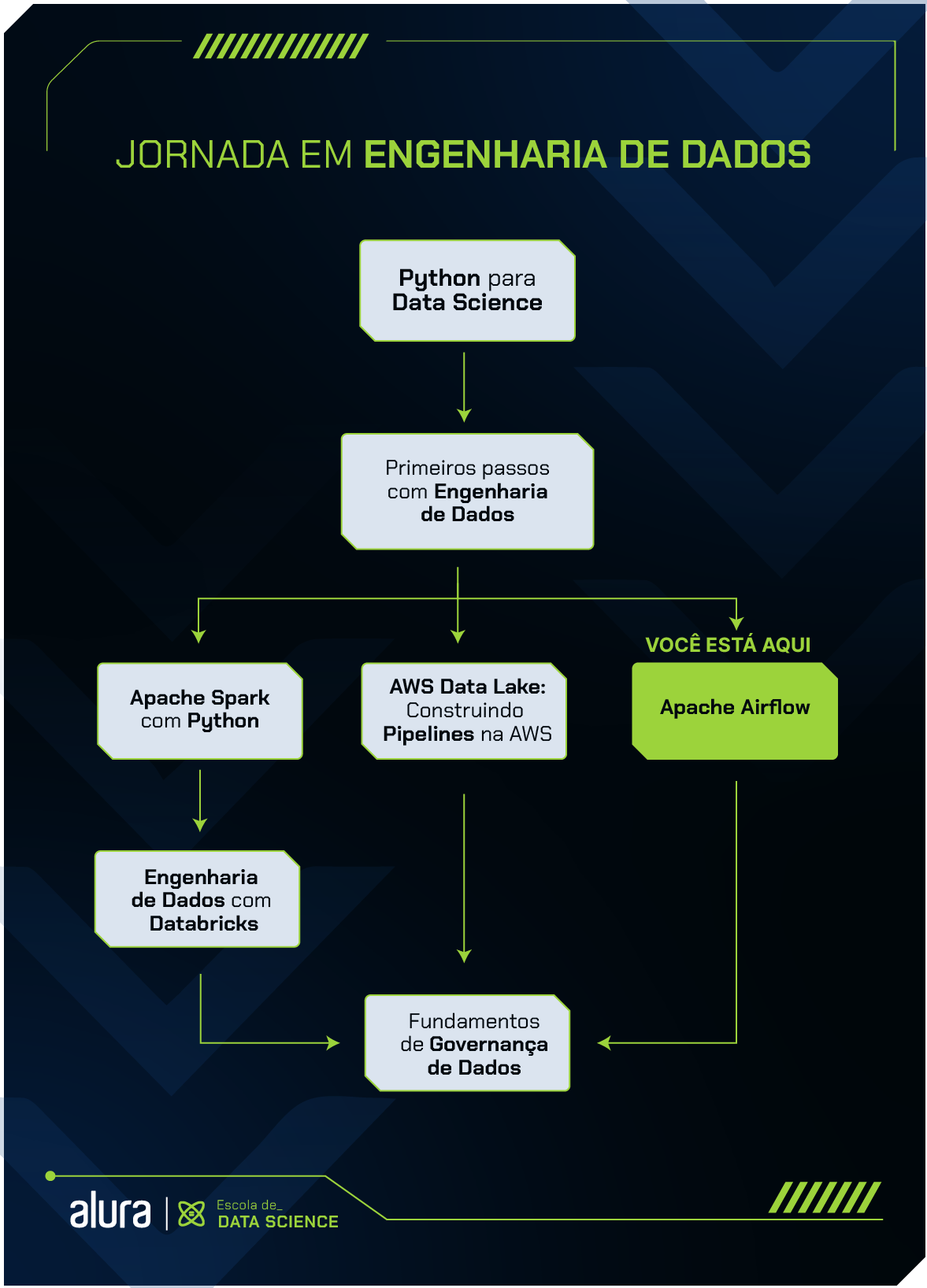

Formações Data Science Apache Airflow

Formação Apache Airflow

Aprenda a criar, programar e monitorar seus pipelines de dados com o Apache Airflow

* Esta formação faz parte dos nossos cursos de Data Science

Quero Estudar na AluraA formação de Apache Airflow busca preparar estudantes para trabalhar com Engenharia de Dados utilizando a linguagem de programação Python e a ferramenta Apache Airflow.

Funciona como um guia de aprendizado para auxiliar pessoas interessadas em entrar no mercado de trabalho e também como mecanismo de consulta para profissionais experientes.

O Apache Airflow é uma ferramenta open source, escrita em Python, criada pelo Airbnb em 2014 e atualmente faz parte da Apache Software Foundation. Trata-se de um orquestrador de fluxos, ou seja, nos permite decidir em qual momento e em quais condições nosso programa irá rodar. É utilizada principalmente para criação, monitoramento e agendamento de pipeline de dados de forma programática.

Nessa formação, vamos aprender a instalar e conhecer a ferramenta Apache Airflow, entendendo e aplicando de forma prática conceitos como: DAGs, orquestração de pipelines e máquinas virtuais.

Você irá construir todo o processo de ETL e terá a oportunidade de se aprofundar nos conceitos de Data Lakes, tratamento e o carregamento de diferentes tipos de camadas.

Por fim, vamos focar nossos estudos nos executores do Airflow e também em como utilizar o Airflow no Kubernetes.

Para aproveitar melhor esse conteúdo, é importante que você já saiba programar em linguagem Python, conheça conceitos básicos de Linux e como executar comandos no terminal.

Conteúdos pensados para facilitar seu estudo

Formação completa para o mercado

Do zero ao sonhado emprego em sua área de interesse

Comece essa formação agora mesmo e capacite-se para seu próximo projeto!

Conheça os planos

Millena Gená é estudante de Ciência da Computação. Atualmente, é Instrutora de Dados aqui na Alura atuando principalmente na área de Engenharia de dados. Ela está sempre procurando aprender algo novo sobre tecnologia e é apaixonada por novas aventuras. Programar e ajudar as pessoas são seus hobbies favoritos! ^^

Millena Gená é estudante de Ciência da Computação. Atualmente, é Instrutora de Dados aqui na Alura atuando principalmente na área de Engenharia de dados. Ela está sempre procurando aprender algo novo sobre tecnologia e é apaixonada por novas aventuras. Programar e ajudar as pessoas são seus hobbies favoritos! ^^

Sou graduado em Ciência da Computação. Atuo como instrutor de Data Science e Machine Learning no Grupo Alura, tendo como principais interesses na tecnologia: criação de modelos e análise de dados. Nas horas vagas assisto e analiso dados de basquete e adoro ouvir podcasts de humor como Nerdcast e Jujubacast.

Sou graduado em Ciência da Computação. Atuo como instrutor de Data Science e Machine Learning no Grupo Alura, tendo como principais interesses na tecnologia: criação de modelos e análise de dados. Nas horas vagas assisto e analiso dados de basquete e adoro ouvir podcasts de humor como Nerdcast e Jujubacast.

Daniel é instrutor na escola de Dados e professor de Matemática, Física, Química e Inglês. Tem verdadeira paixão em aprender coisas e assuntos novos, e transmitir seus conhecimentos.

Daniel é instrutor na escola de Dados e professor de Matemática, Física, Química e Inglês. Tem verdadeira paixão em aprender coisas e assuntos novos, e transmitir seus conhecimentos.

Bruno é um instrutor de Data Science e Engenheiro Eletricista pela Universidade Federal do Piauí. Se dedica em áreas como Data Science, Machine Learning e Deep Learning, e possui grande interesse em engenharia de dados e engenharia de machine learning. Além disso, em seu tempo livre, ele gosta de jogar xadrez, tocar instrumentos musicais e jogar League of Legends.

Bruno é um instrutor de Data Science e Engenheiro Eletricista pela Universidade Federal do Piauí. Se dedica em áreas como Data Science, Machine Learning e Deep Learning, e possui grande interesse em engenharia de dados e engenharia de machine learning. Além disso, em seu tempo livre, ele gosta de jogar xadrez, tocar instrumentos musicais e jogar League of Legends.

Neste passo inicial, preparamos um conteúdo para ajudar você a conhecer melhor o Apache Airflow e como iniciar um projeto com essa ferramenta.

Na primeira etapa dessa jornada, você vai aprender a configurar e instalar o Airflow, além de compreender seus principais conceitos e funcionalidades. No final dessa etapa, você será capaz de desenvolver e orquestrar seu primeiro pipeline de dados.

Artigo Airflow - Entendendo os DAGs

Curso Apache Airflow: orquestrando seu primeiro pipeline de dados

08h

Alura+ Criando máquinas virtuais com o VMWare

Alura+ Instalando o Airflow no Docker

Agora que você já aprendeu a orquestrar seu primeiro pipeline de dados, vamos construir um novo pipeline que fará a extração e a transformação de dados, combinando a ferramenta Airflow para orquestração do pipeline e a ferramenta Spark para transformação dos dados.

Além disso, vamos armazenar esses dados em um Data Lake. Completando assim todas as etapas de um ETL (Extract, Transform, Load). No final dessa etapa, você será capaz de desenvolver e orquestrar um pipeline de dados com um processo ETL.

Alura+ O que são Data Lakes?

Podcast Data Lakes – Hipsters Ponto Tech #269

Curso Apache Airflow: extração de dados

10hCurso Apache Airflow: transformação de dados com Spark

10hEssa etapa mostra como configurar e utilizar os diferentes executores do Airflow. Estes executores são mecanismos que lidam com a execução de tarefas. O Airflow possui vários destes mecanismos e a diferença entre eles se resume aos recursos que possuem e à forma como trabalham na execução das tarefas.

Durante essa etapa você vai aprender a configurar diferentes executores, como: Local, Celery e Kubernetes.

Artigo Executores do Airflow: tipos e funções

Curso Aprofundando no Airflow: Executores Local e Celery

08h

Artigo Kubernetes: conhecendo a orquestração de containers

Curso Aprofundando no Airflow: Executor Kubernetes

08hEscola

Além dessa, a categoria Data Science conta com cursos de Ciência de dados, BI, SQL e Banco de Dados, Excel, Machine Learning, NoSQL, Estatística,e mais...

Conheça a EscolaImpulsione a sua carreira com os melhores cursos e faça parte da maior comunidade tech.

1 ano de Alura

Assine o PLUS e garanta:

Formações com mais de 1500 cursos atualizados e novos lançamentos semanais, em Programação, Inteligência Artificial, Front-end, UX & Design, Data Science, Mobile, DevOps e Inovação & Gestão.

A cada curso ou formação concluído, um novo certificado para turbinar seu currículo e LinkedIn.

No Discord, você tem acesso a eventos exclusivos, grupos de estudos e mentorias com especialistas de diferentes áreas.

Faça parte da maior comunidade Dev do país e crie conexões com mais de 120 mil pessoas no Discord.

Acesso ilimitado ao catálogo de Imersões da Alura para praticar conhecimentos em diferentes áreas.

Explore um universo de possibilidades na palma da sua mão. Baixe as aulas para assistir offline, onde e quando quiser.

Acelere o seu aprendizado com a IA da Alura e prepare-se para o mercado internacional.

1 ano de Alura

Todos os benefícios do PLUS e mais vantagens exclusivas:

Luri é nossa inteligência artificial que tira dúvidas, dá exemplos práticos, corrige exercícios e ajuda a mergulhar ainda mais durante as aulas. Você pode conversar com a Luri até 100 mensagens por semana.

Aprenda um novo idioma e expanda seus horizontes profissionais. Cursos de Inglês, Espanhol e Inglês para Devs, 100% focado em tecnologia.

Transforme a sua jornada com benefícios exclusivos e evolua ainda mais na sua carreira.

1 ano de Alura

Todos os benefícios do PRO e mais vantagens exclusivas:

Mensagens ilimitadas para estudar com a Luri, a IA da Alura, disponível 24hs para tirar suas dúvidas, dar exemplos práticos, corrigir exercícios e impulsionar seus estudos.

Envie imagens para a Luri e ela te ajuda a solucionar problemas, identificar erros, esclarecer gráficos, analisar design e muito mais.

Escolha os ebooks da Casa do Código, a editora da Alura, que apoiarão a sua jornada de aprendizado para sempre.